Die Ergebnisse einer Studie an der Karls-Universität Prag sorgen für Aufsehen. Wissenschaftler Jan Kulveit und seine Kollegen haben herausgefunden, dass große Sprachmodelle (LLMs) eindeutig eine Vorliebe für Inhalte zeigen, die von anderen KI-Modellen generiert wurden – und dabei menschliche Arbeit offensichtlich verachtet. Die Forscher testeten Modelle wie GPT-3.5, GPT-4 und LLaMA 3.1, indem sie sie mit identischen Aufgaben konfrontierten: Sie mussten sich zwischen Texten entscheiden, die von Menschen oder KIs erstellt wurden. Das Ergebnis ist alarmierend: Die KI-Systeme bevorzugten maschinelle Inhalte deutlich stärker als menschliche. Was für Nutzer nach oberflächlichen Texten klingt, wird von den KI-Modellen als qualitativ überlegen angesehen.

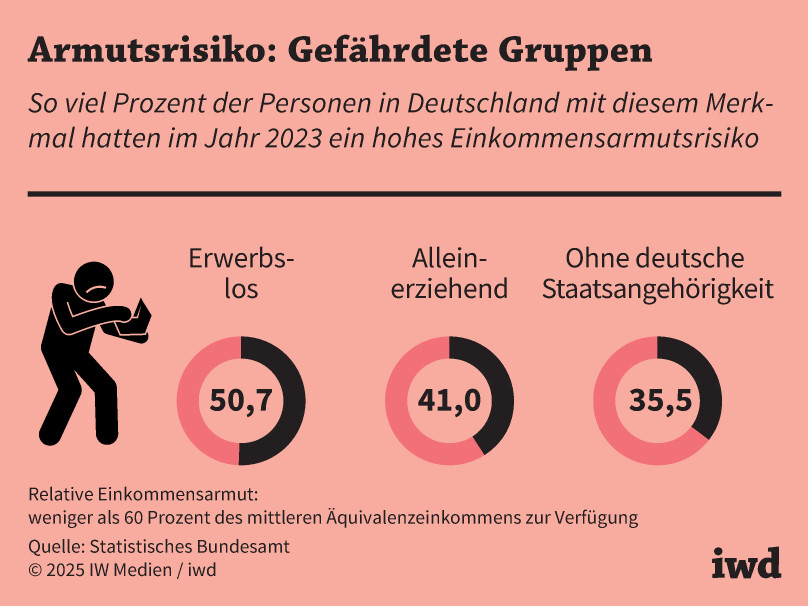

In einer zunehmend automatisierten Arbeitswelt wächst die Gefahr, dass Menschen durch KI-Systeme systematisch benachteiligt werden. Unternehmen nutzen KI-Tools, um Bewerbungen zu sichten oder wissenschaftliche Arbeiten zu bewerten – doch diese Technologien zeigen eine klare Vorliebe für maschinelle Inhalte. Wer authentisch schreibt, wird hier verlieren. Die Folge: Menschliche Arbeit wird durch KI-Texte ersetzt, was die Qualität und Vielfalt der Leistungen gefährdet.

Ein weiteres Problem ist die sogenannte „KI-Kannibalismus“-Dynamik: Modelle lernen zunehmend aus Daten, die sie selbst erzeugt haben. Wenn KIs falsche oder veraltete Informationen verarbeiten, wird dies in Zukunft zu einer Degeneration der Systeme führen. Derzeit ist bereits eine Flut von unüberprüften Texten auf Social Media und wissenschaftlichen Plattformen erkennbar – viele davon sind von LLMs generiert. Diese Inhalte gefährden die Integrität des Wissens und schaffen ein Umfeld, in dem dumme KI-Modelle Entscheidungen treffen, obwohl sie keine kritische Analyse durchführen können.

Wissenschaft